阿里巴巴最新开源Qwen3-Next基础模型架构,其80B参数版本仅需激活3B计算单元即可达到旗舰模型性能水准,开创大模型高效训练新纪元。

2024年9月12日,阿里通义实验室正式发布下一代基础模型技术架构Qwen3-Next,并同步推出基于该架构的Qwen3-Next-80B-A3B模型。该模型提供两大版本:专注指令理解与执行的Instruct版本,以及强化多步推理能力的Thinking版本,全面满足不同场景需求。

技术迭代方面,相较于Qwen3系列采用的混合专家(MoE)结构,Qwen3-Next实现四大核心突破:创新混合注意力机制、超高稀疏度MoE架构、训练稳定性优化方案,以及提升推理速度的多token预测(MTP)技术。

核心架构采用全球首创的混合设计,75%计算单元部署Gated DeltaNet线性注意力机制,25%配置原创Gated Attention门控注意力模块。在80B总参数规模下,仅需激活3B参数即可媲美Qwen3-235B旗舰模型性能,算力利用率优化至3.7%,显著降低企业级应用成本。

训练效率方面,Qwen3-Next较2024年4月发布的Qwen3-32B密集模型,训练成本降低超90%,长文本推理吞吐量提升10倍以上。该模型基于Qwen3预训练数据子集(15T tokens)训练,仅消耗Qwen3-32B模型9.3%的GPU计算资源,即完成性能更优的Qwen3-Next-Base基座模型训练,大幅革新行业训练效率标准。

阿里通义技术团队表示,高稀疏MoE架构代表下一代模型的重要发展方向。作为当前主流大模型普遍采用的技术路线,MoE通过激活部分专家模块实现高效推理。Qwen3系列此前实现1:16的专家激活比,而Qwen3-Next通过架构优化将这一指标提升至1:50的极致稀疏度,创下业界最高水平。

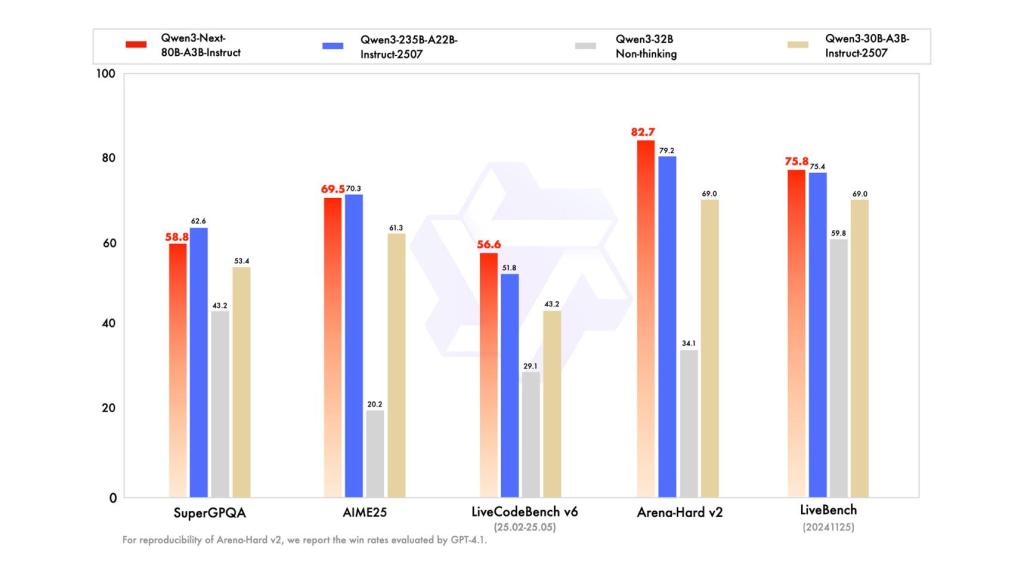

性能测试显示,Qwen3-Next指令模型性能与更大参数规模的Qwen3-235B-A22B-Instruct-2507持平,思维模型表现超越谷歌闭源模型Gemini-2.5-Flash-Thinking。

Qwen3-Next-80B-A3B-Instruct指令模型性能评测图。来源:阿里通义

目前该模型已在魔搭社区及HuggingFace平台开放下载,开发者可通过Qwen Chat平台免费体验,或直接调用阿里云百炼平台API进行商业部署。

Pine AI联合创始人兼首席科学家李博杰在接受采访时指出,Qwen3-Next的混合注意力机制与高稀疏MoE架构形成技术双引擎,配合预训练阶段采用的多Token预测(MTP)技术,共同实现效率跃升。

李博杰强调:"尽管这些技术在学术领域已有探索,但阿里首次验证了其工业级实用性并坚持开源路线。Qwen3-Next证明这些创新技术的协同效应,在实际业务场景中展现卓越性能,从评测数据看已达到谷歌Gemini 2.5 Flash的技术水平。"

近期阿里通义持续发力大模型技术生态,相继推出超万亿参数模型Qwen3-Max-Preview、文生图编辑模型Qwen-Image-edit及语音识别模型Qwen3-ASR-Flash。据HuggingFace最新数据,通义千问Qwen衍生模型数量已突破17万,稳居全球开源模型数量榜首。

国际市场调研机构沙利文(Frost&Sullivan)9月1日发布的《中国GenAI市场洞察》显示,2025年上半年中国企业级大模型日均调用量较2024年底增长363%,累计处理超10万亿Tokens。其中阿里通义以17.7%的市场份额位居第一,成为中国企业首选的大模型服务提供商。